我们提供定制开发领英用户数据批量自动采集的工具和服务,We provide LinkedIn bot to extract user data chat bot!

您是否厌倦了在 LinkedIn 上手动搜索用户资料?人工采集不但工作量巨大,而且效率低下。不用担心,我们自主开发的 LinkedIn 数据采集机器人来了!这款高级机器人使用人工智能算法,帮助用户通过关键词搜索领英用户的邮箱和电话号码,还可以整理出用户的技能、经验和偏好等等用户数据,尝试与您的精准潜在用户需求相匹配。同时,还具有无人值守的自动化采集、个性化消息发送和实时更新等功能,您将永远不会错过领英平台上的重要商机:我们提供领英用户资料和联系方式采集的工具和服务,We provide LinkedIn scrape software & service. 我们的工具如何绕过平台的反爬虫机制无限采集?

自动抓取LinkedIn用户数据,可以为出海企业的拓展、拉新、获客节省时间,自动抓取领英用户数据可以节省时间和精力,比起手动输入或在LinkedIn上搜索信息来说更加高效。准确性更高,我们|飞机号: t.me/bulk006|开发的领英用户自动抓取工具可以确保数据的准确性和一致性,这对于开发海外新客户说尤为重要,因为准确的联系信息是拓展出海业务的关键。效率高,自动抓取可以帮助简化拓展过程,提供一个中心化的数据源,使得更容易识别和连接潜在客户或合作伙伴。可扩展性强,随着数据量的增加,自动抓取可以帮助更好地扩展开发新客工作,使得能够更快速和全面地收集用户数据。成本效益,自动抓取数据可以是带来成本效益的海外市场开发方式,特别是相比于雇用数据输入人员或使用昂贵的数据收集工具。实时数据采集,自动抓取可以提供实时数据,这对于海外客户拓展来说至关重要,例如快速响应潜在客户或更加精准的识别潜在合作伙伴。可定制性,自动抓取可以根据特定的拓展目标和目标进行定制,例如收集特定行业、职能或地理位置的数据。持续更新迭代和优化,自动抓取可以帮助持续改进海外市场拓展活动,提供数据洞察,帮助识别需要改进的领域。

虽然市面上针对LinkedIn平台采集用户的工具五花八门,但自动抓取LinkedIn用户数据一定会违反领英的服务条款和相关平台规则。所以,如果工具没有能力去规避平台的反爬虫机制,建议还是购买我们的工具较为稳妥:我们提供LinkedIn采集工具和服务,We provide LinkedIn extractor. 为何我们的采集工具性价比远高于Hunter 或 Clearbit等第三方服务?相比其他同类工具,我们的工具功能优势在于:

• 自动化追踪和重新采集领英用户个人资料的更新:机器人可以随时监控到任何用户的 LinkedIn 个人资料变动,如果他们的profile添加了任何新的信息,如工作变动、职位变更、技能或成就,我们的工具会自动采集新用户资料并更新到本地数据库保存。

• 领英用户的个人资料完善:机器人可以辨识任何领英用户的 LinkedIn 个人资料中缺失的信息,如专业摘要或技能部分。然后,从其他渠道(例如谷歌搜索)采集到这些信息、并补充完善到本地的采集资料中保存。

• 拟人化的连接请求:机器人可以发送个性化的连接请求,并模拟出真人行为,避免爬虫被领英服务器封禁。

• 个人资料优化:在完成采集之后,如果你希望与这些精准的潜在客户建联,我们这个工具的机器人可以优化您的 LinkedIn 个人资料,以提高搜索引擎的可见性,并通过DM群发的方式联系这些领英用户:我们提供领英群发工具和服务,We provide LinkedIn mass messaging software & service!

• 发布和分享:机器人可以登录多个领英账号,设定发布和分享更新、文章和其他内容。

• 评论和喜欢互动:机器人可以与他人的帖子互动,通过评论和喜欢。

• 机器人类型和功能可根据出海营销人员的需求定制。

• 购物/订购,机器人可以在采集完领英用户后向其直推InMail开启营销。

• 客户服务,机器人在采集完LinkedIn用户之后,批量给他们到招呼建联。

• 社交媒体互动,机器人在采集完LinkedIn用户之后,可以批量关注其profile并打招呼。

• 领英平台批量养号功能

• Python

• Botsify

• Node.js

• 其他

Auto-scraping LinkedIn user data can be important for outreach:

Time savings: Scraping data automatically can save time and effort compared to manual data entry or searching for information on LinkedIn.

Accuracy: Automatic scraping can help ensure accuracy and consistency in the data collected, which is particularly important for outreach efforts where accurate contact information is critical.

Efficiency: Automatic scraping can help streamline the outreach process by providing a centralized source of contact information and other relevant details, making it easier to identify and connect with potential clients or partners.

Scalability: As the volume of data increases, automatic scraping can help scale the outreach efforts more efficiently, allowing for faster and more comprehensive data collection.

Cost-effective: Automatic scraping can be a cost-effective way to collect data, especially when compared to hiring a team of data entry staff or using expensive data collection tools.

Real-time data: Automatic scraping can provide real-time data, which is essential for outreach efforts where timeliness is critical, such as responding to a lead or identifying potential partners.

Customizable: Automatic scraping can be customized to meet specific outreach goals and objectives, such as collecting data on specific industries, job functions, or geographic locations.

Continuous improvement: Automatic scraping can help continuously improve the outreach efforts by providing insights into the effectiveness of the campaigns and helping to identify areas for improvement.

However, it's important to note that auto-scraping LinkedIn user data may also raise ethical and legal concerns, such as privacy violations and potential legal liabilities. Therefore, it's essential to ensure that any auto-scraping activities are conducted in compliance with LinkedIn's terms of service and applicable laws and regulations.

自動抓取LinkedIn用戶數據的技術路徑是怎樣的?自動和批量抓取LinkedIn用戶數據,涉及使用網頁抓取技術來從LinkedIn個人資料中提取數據。以下是我们|飞机号: t.me/bulk006|开发的这个工具的技术路线概述:我们提供批量采集领英1,2,3度联系人的工具和服务,We provide LinkedIn connections data software & service!

選擇一種程式語言:Python是一種流行的程式語言,用於網頁抓取,因為它的簡單性和廣泛的庫。

安裝必要的庫:Beautiful Soup、Requests和Selenium是常用的網頁抓取庫。

檢查LinkedIn頁面:使用網頁瀏覽器的開發人員工具來檢查LinkedIn個人資料的HTML結構。識別包含您想要抓取的數據的元素。

編寫腳本:使用選擇的程式語言來編寫一個腳本,該腳本可以訪問LinkedIn個人資料,提取所需的數據,並將其保存到檔案或數據庫。

處理反抓取措施:LinkedIn可能會實現反抓取措施,例如CAPTCHA或速率限制。您可能需要使用技巧,例如輪替IP地址或使用代理伺服器來繞過這些措施。

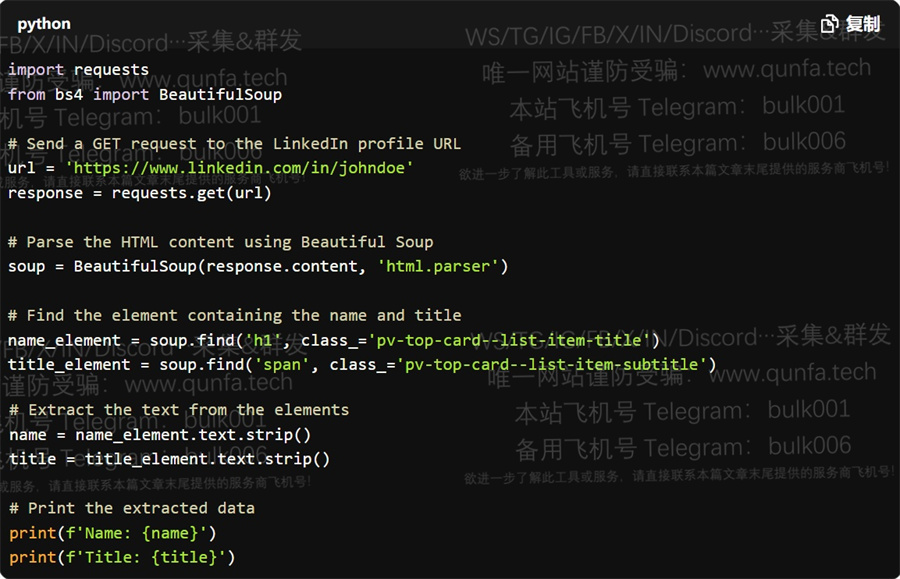

以下是一個簡單的Python代碼示例,用於使用Beautiful Soup從LinkedIn個人資料中提取名字和職稱:

請注意,這只是一個簡單的示例,您可能需要根據具體需求進行修改。此外,請注意,抓取LinkedIn數據一定会違反其服務條款,所以我们的工具已经部署了绕过其反爬机制的功能,而无需其他驗證或授權步驟。除了采集LinkedIn用户数据,我们还有另外一款采集工具,可以:(1)自动在17个SNS社媒平台上采集海量用户和红人联系方式。

Auto-scraping LinkedIn user data involves using web scraping techniques to extract data from LinkedIn profiles. Here's a high-level overview of the technical path:

Choose a programming language: Python is a popular choice for web scraping due to its simplicity and extensive libraries.

Install required libraries: Beautiful Soup, Requests, and Selenium are commonly used libraries for web scraping.

Inspect LinkedIn pages: Use the developer tools in your web browser to inspect the HTML structure of LinkedIn profiles. Identify the elements that contain the data you want to scrape.

Write a script: Use the chosen programming language to write a script that navigates to LinkedIn profiles, extracts the desired data, and saves it to a file or database.

Handle anti-scraping measures: LinkedIn may implement anti-scraping measures such as CAPTCHAs or rate limiting. You may need to use techniques such as rotating IP addresses or using proxies to bypass these measures.

在完成领英用户数据采集之后,就可以使用我们提供领英群发工具和服务,We provide LinkedIn mass messaging software & service! 与这些用户建立联系、或者直接批量发消息私聊推广自己的出海业务。

Here's an example code snippet in Python using Beautiful Soup to scrape the name and title of a LinkedIn profile: see above codes screenshot!

Note that this is just a simple example, and you may need to modify the code to suit your specific needs. Additionally, be aware that scraping LinkedIn data may be subject to their terms of service and may require additional authentication or authorization steps.

如何联系本文提及的各种应用和自动化营销工具的开发者:如需定制开发各种出海应用及自动化工具,可加此开发者的飞机号了解更多,他们的Telegram账号是:t.me/ajatar (Eng pls)

We are looking for agents to distribute our software & service worldwide, including CHINA!